DeepSeek 导航网:Ollama 是一个开源框架,专为在本地设备上便捷部署和管理大型语言模型(LLM)而设计。它通过简化模型安装、运行和配置流程,降低了用户使用门槛,支持多种主流模型(如 Llama 2、DeepSeek 等),并支持跨平台操作(Windows、macOS、Linux)。

Ollama 下载与部署 DeepSeek 模型指南

1. 安装与配置

- 下载安装:

- 访问官网(ollama.com)选择对应系统安装包。 Windows 用户可通过命令指定安装路径(如

OllamaSetup.exe /DIR=d:\Ollama)避免占用 C 盘空间4。 - 安装后需手动添加环境变量

OLLAMA_MODELS,设置模型存储路径(如D:\Ollama\models)。

- 访问官网(ollama.com)选择对应系统安装包。 Windows 用户可通过命令指定安装路径(如

- 验证安装:终端输入

ollama --version显示版本号即成功。

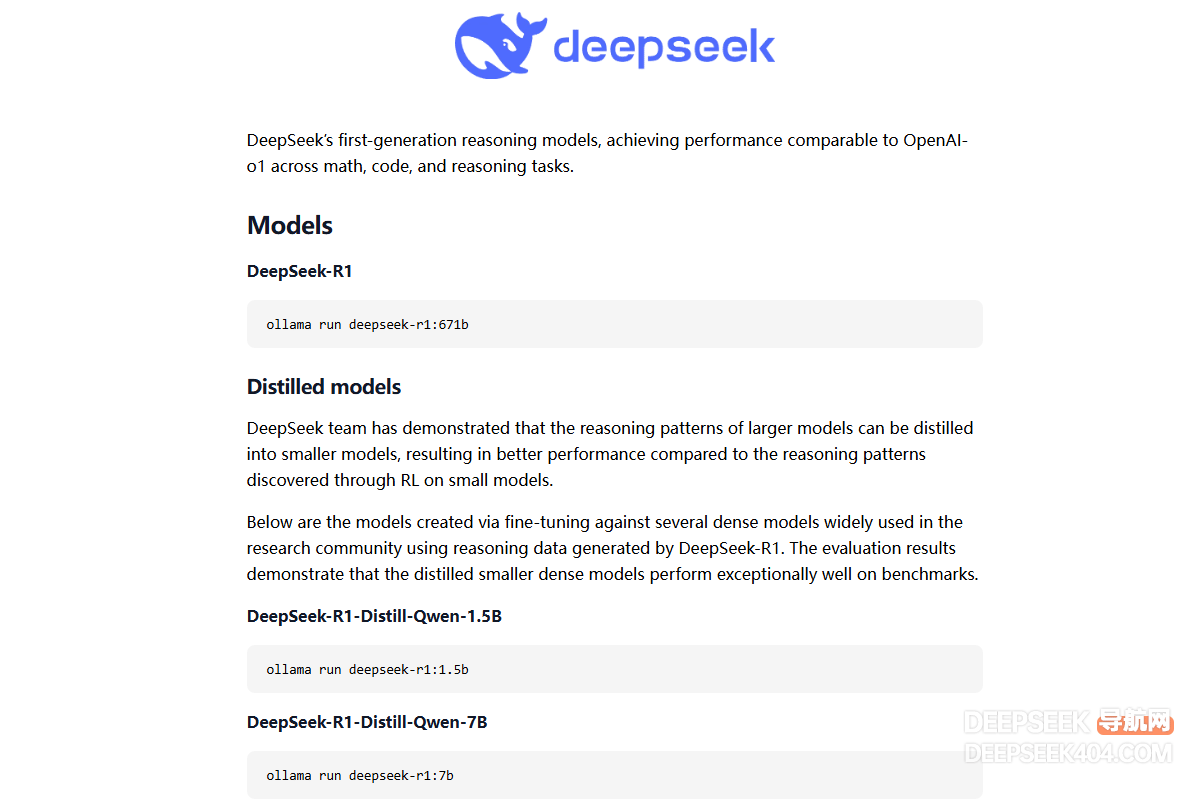

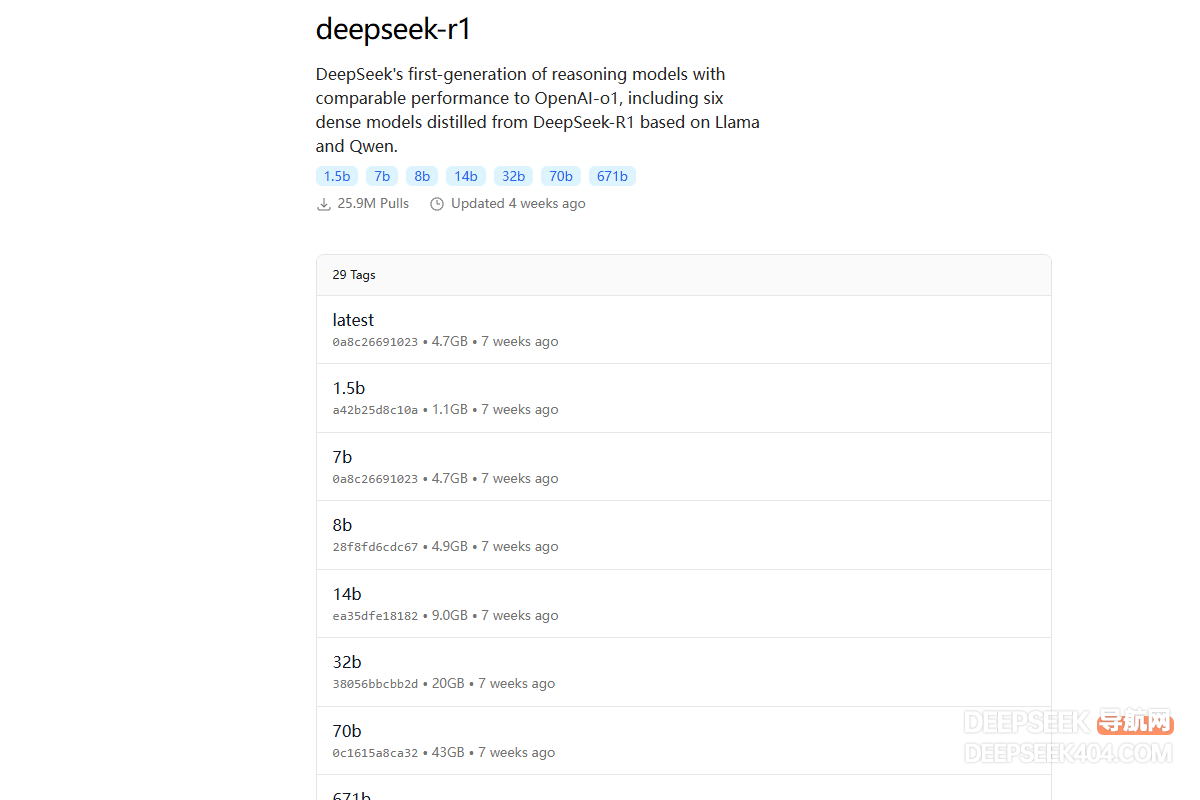

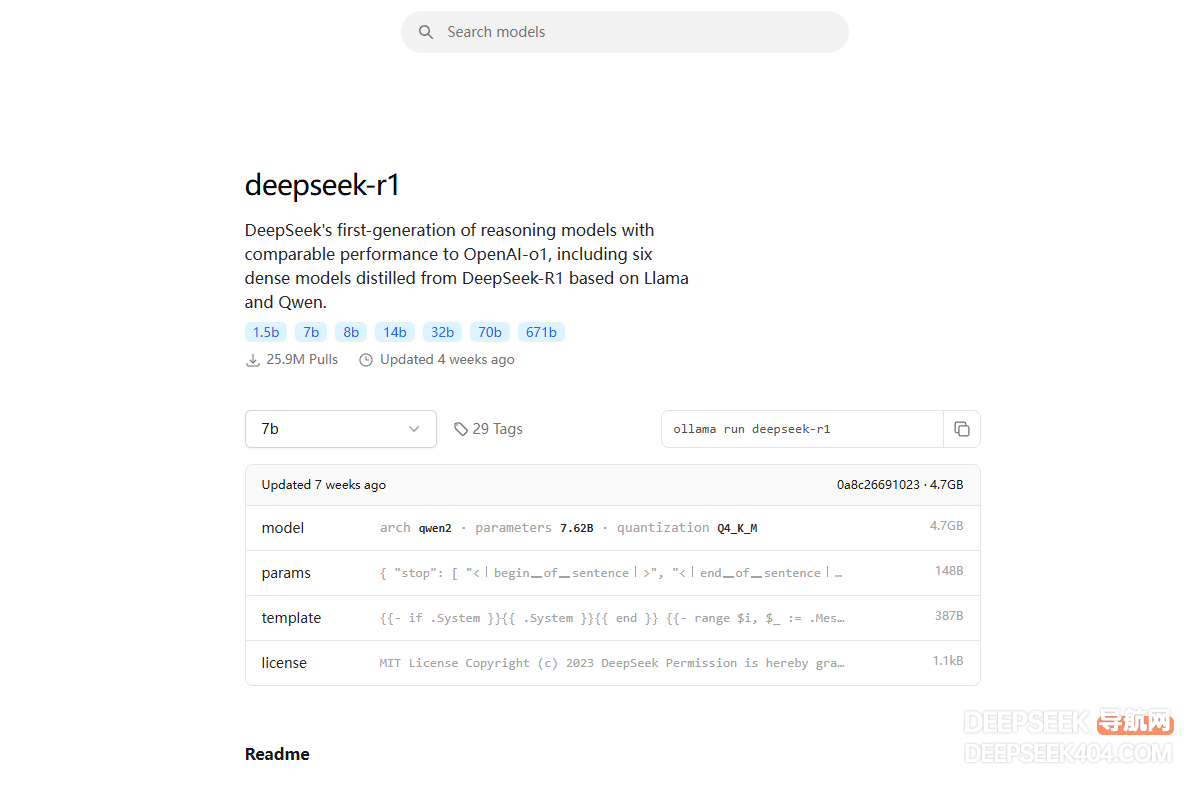

2. DeepSeek 模型下载

- 模型选择:根据硬件配置选择参数规模(1.5B/7B/8B/14B/32B/70B)。例如:

- 入门测试:

ollama run deepseek-r1:1.5b(占用 1.1GB 空间)。 - 高性能需求:推荐 8B(4.9GB)或 14B(9GB)版本。

- 入门测试:

- 下载命令:终端输入

ollama pull deepseek-r1或直接运行ollama run deepseek-r1:8b,模型将自动下载至预设路径。

3. 安全风险与注意事项

- 未授权访问:Ollama 默认开放 11434 端口且无鉴权机制,暴露公网可能导致模型窃取或数据泄露。建议修改默认配置并限制端口访问。

- 资源占用:大模型需较高硬件配置(如 8B 模型需 16GB 内存),量化可缓解资源压力。

集成了丰富的免费AI课程,大模型社区及模型应用