DeepSeek 导航网:DeepSeek-R1-0528 新版本模型最新开源,在数学推理、代码生成等领域实现了突破性性能提升,并且显著降低了幻觉,核心性能指标达到领先闭源模型水平。对于需要进行 DeepSeek 模型本地化部署的用户来说,使用 0528 版本替代原版 R1 模型能够进一步提升业务能力。

今天为大家分享一款开源工具 OpenStation ,其已经适配了 Deepseek-R1-0528 新版模型,可以无代码在集群内快速完成新模型的服务部署与分发,这款工具还提供简单高效的服务管理与资源管理功能,帮助企业级用户在本地服务器上安全便捷地部署与使用 DeepSeek-R1-0528 版本模型。

如下是工具开源主页,可以去下载并了解详情,有问题还可以通过项目主页的“用户交流”模块加入群聊和技术专家沟通咨询:

OpenStation 开源主页:访问

软件介绍

OpenStation 是一款专为企业和开发者设计的一站式大模型部署管理平台,帮助用户快速、便捷地部署和体验大模型服务能力。平台提供完整的模型管理、服务部署与用户协作功能,兼容标准 OpenAI API 接口,内置高效推理引擎,并提供灵活的资源扩缩容和精细的权限管理机制。

OpenStation 的主要特点包括:

- 简单易用:通过页面化的操作,仅需几步点击即可快速完成 DeepSeek 等大模型的部署

- 标准接口:部署的服务提供标准的 OpenAI API 兼容接口,方便多种客户端工具快速接入

- 高性能:支持 SGLang、vLLM 及 CPU 部署方式,支持单机及分布式部署,提供高效灵活的推理引擎能力

- 便捷资源管理:通过页面化的操作,实现平台节点资源的快速添加与删除

- 负载均衡:提供统一推理服务入口,支持服务无感知的快速扩容和缩容能力

- 用户鉴权管理:支持用户维度的 API-key 鉴权管理,实现推理服务的访问权限控制

使用方法

1.部署模型

在 OpenStation 内可以便捷地部署 Deepseek 和 Qwen3 大模型,点击模型的对应版本名称即可自动化下载模型,其中 DeepSeek-R1-0528 最新版本模版已经完成适配。

OpenStation 也支持传入用户指定的其他本地模型进行部署。根据部署过程中选择的计算资源, OpenStation 会使用 vLLM、SGLang 等不同的框架对推理服务提供 CPU、GPU 加速。

服务部署之后,即可获得大模型的推理服务 API 。在界面内可以查看推理服务的资源占用量和健康状况、查看服务日志信息。

2.分发服务

OpenStation 可以配置邮箱服务器,并将推理服务访问信息分发给指定用户,简化大模型服务的批量管理。

根据配置信息,在上线服务后会将新服务的使用方法以邮件形式通知 OpenStation 的用户。

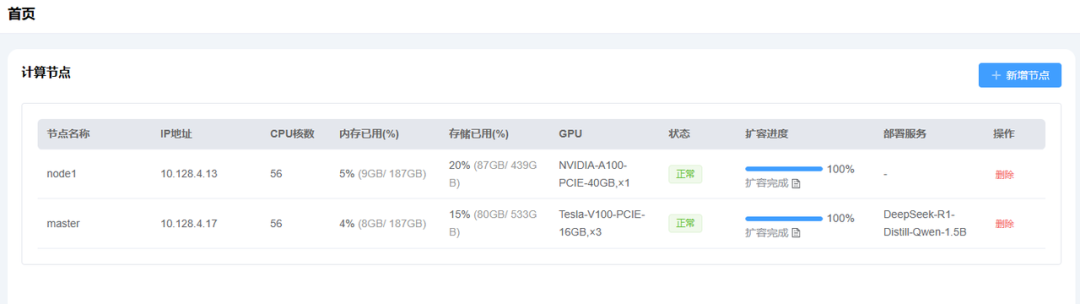

3.资源管理

OpenStation 能够统一管理多个服务器上的计算资源和服务调度,在界面内可以直观查看资源占用信息和运维信息,并对服务部署情况进行总览。

OpenStation 提供了便捷的集群节点扩容和缩容能力,在界面内填入指定服务器的基础信息后, OpenStation 即可将对应服务器纳入到服务部署管理范围内。

可以在开源社区获取 OpenStation 的下载包或下载脚本,了解详细使用方法。同时,在“用户交流”模块,还可以加入专家沟通群聊,实时咨询问题并提出产品建议:

下载地址

- 官方网站:访问

LLM网页